Поддельные новости — это явление, которое труднее отличить от реальных новостей не только из-за самого содержания статей и их вирусного воздействия на социальные сети, но и потому, что теперь становится все проще создавать действительно реалистичные поддельные видеоролики и фотографии. Кроме того, поддельные новости — не очень хорошая практика еще и потому, что они влияют на поведение людей, результаты выборов и помогают мошенникам совершать их плохие деяния. Представьте себе, что произойдет, если искусственный интеллект сможет создавать поддельные, но реалистичные видео с людьми из одной лишь их фотографии. Samsung как раз на днях разработала новый ИИ, который может это сделать.

Внутри лаборатории искусственного интеллекта, расположенной в России, ИИ Samsung научили фабриковать поддельные видеоклипы с людьми, имея в распоряжении только одну фотографии или даже картину. И это даже выглядит вполне реалистично. Один из опубликованных видеороликов показывает, как Мона Лиза Леонардо да Винчи движется и разговаривает, а ведь картина была единственным изображением Моны Лизы, которое использовалось для создания видео, поскольку ее других изображений попросту не существует. До настоящего момента для создания фейковых видеороликов, чтобы обеспечить реалистичный результат, требовалось много изображений, но благодаря усилиям южнокорейского гиганта теперь требуется всего одна фотография.

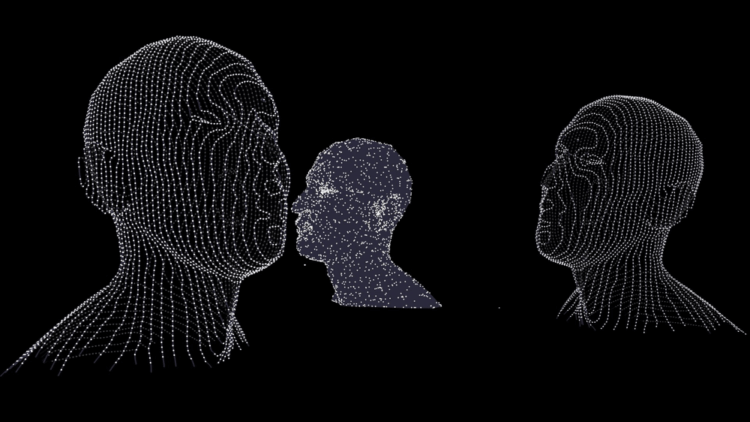

Новое творение Samsung называется «realistic neural talking heads» (реалистичные нейронные говорящие головы), и слово «нейронные» здесь применено не просто для красного словца. Нейронные сети — это тип машинного обучения, способный имитировать человеческий мозг, и они имеют много общего с новым алгоритмом Samsung. Для создания видеоклипа ИИ просматривает множество видеороликов, чтобы узнать, как движутся человеческие лица, а затем применяет все полученные знания на создание реалистичного видео всего лишь из одной фотографии.

Существует много направлений, которые могли бы извлечь выгоду из такой технологии, но я надеюсь, что она не будет использоваться для создания поддельных вирусных видео или шантажа.